Poslední generace GeForce RTX, včetně nejnovější řady 50, dokázaly navýšit výkon v této oblasti dostatečně na to, aby zvládly akcelerovat umělou inteligenci i lokálně.

Provozování modelů na vlastním PC má řadu výhod od úspory za předplatné služeb přes ochranu soukromí, protože svá data nemusíte nikam odesílat, po snadnou možnost trénovat si vlastní neuronové sítě.

RTX PC dokážou trénovat AI modely až 30× rychleji, zvyšují snímkovou frekvenci až 8× a urychlují generování obrázků až 13×, v porovnání s běžným PC bez dedikované GPU NVIDIA.

NVIDIA NIM a Bluperints pro jednoduché nastavení

Společnost NVIDIA nedávno přišla se svými NIM (NVIDIA Inference Microservices). Jde o sadu mikroslužeb na bázi kontejnerů s optimalizovaným generativní a inferenčními AI modely navrženými pro jednoduchou integraci do aplikací jako NVIDIA Chat RTX, AnythingLLM, Crew AI nebo Comfy UI. Mohou sloužit k chytrému vyhledávání, generování nebo analýze obrázků, zadávání příkazů v přirozeném jazyce a dalším potřebám.

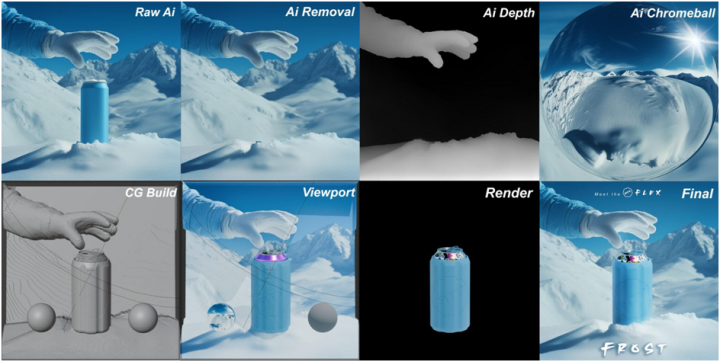

Mezi nové přírůstky mezi NVIDIA NIM patří populární model FLUX.1 Kontext [dev] pro generování a editaci obrázků. Disponuje průvodcem, který krok za krokem provádí proces generování, což usnadňuje kontrolu nad vývojem obrázku, ať už jde o vylepšení drobných detailů nebo transformaci celé scény. Protože model přijímá jak textové, tak obrazové vstupy, mohou uživatelé snadno odkazovat na vizuální koncept a řídit vývoj přirozeným a intuitivním způsobem.

Aktuálně FLUX.1 Kontext [dev] také disponuje optimalizacemi TensorRT a pokročilou kvantizací, díky čemuž se požadavky na VRAM snížily z 24 GB na pouhých 7 GB (FP4) nebo 12 GB (FP8) a výkon je více než dvojnásobný ve srovnání s původním modelem. Dříve tato zrychlení vyžadovala pokročilé znalosti infrastruktury AI, ale nyní je může kdokoli vložit do nástrojů, jako je ComfyUI, a okamžitě začít tvořit.

A současně s NIM byly odhaleny také AI Blueprints. Jak již název napovídá, jde o předem připravené ukázkové pracovní postupy využívající AI model nebo jejich kombinaci ke konkrétnímu účelu a jejich nasazení je relativně snadné. Většina z nich je navržena pro běh v cloudu, NVIDIA si však již připravila příklad lokálního nasazení jménem 3D Guided Generative AI.

AI usnadní podnikání

Možnosti využití GPU NVIDIA RTX pro lokální běh AI jsou širší, než by se mohlo zdát. Umělou inteligenci mohou úspěšně využít dokonce i menší podnikatelé. Příkladem může být Marka Theriault, který vybudoval svou značku izolačních obalů a chladících puků FITY jen s pomocí 3D tiskárny, GeForce RTX 4080 SUPER a AI. Tato kombinace nástroje mu pomohly navrhnout jak produkt, tak marketingovou kampaň k němu a umělá inteligence v podobě velkého jazykového modelu mu pomohla i při sepisování patentových přihlášek.

„V posledních několika měsících jsem přešel od vykreslování s pomocí AI k plně AI generovaným snímkům pomocí vlastního Flux LoRA, který jsem vycvičil ve firmě. Moje RTX 4080 SUPER byla nezbytná pro rychlé školení a iterace,“ komentuje možnosti Theriault.

Nová éra otevřené AI

Srpen přinesl další milník. Společnosti OpenAI a NVIDIA oznámily spolupráci na optimalizaci otevřených modelů gpt-oss-20b a gpt-oss-120b pro běh na desktopových strojích s RTX GPU. Modely nyní umožňují inteligentní a rychlou lokální inferenci s výkonem až 256 tokenů za sekundu na GPU RTX 5090. Jako u všech lokálně běžících modelů i zde platí, že data zůstávají v bezpečí PC a není třeba je posílat do cloudu.

Generální ředitel NVIDIA Jensen Huang k tomu uvedl: „OpenAI ukázala světu, co lze na technologii NVIDIA AI postavit – a nyní posouvá inovace v open–source ještě dál. Modely gpt-oss umožní vývojářům po celém světě stavět na nejmodernějším otevřeném základu.“

Pro uživatele je nejrychlejší cestou k využití těchto modelů aplikace Ollama. Stačí RTX GPU s min. 24 GB VRAM, nainstalovat Ollamu a vybrat model z rozbalovací nabídky. Díky plné optimalizaci pro RTX není potřeba žádné složité nastavení . Vše funguje „out-of-the-box“.

Nová verze aplikace navíc umožňuje nahrávat PDF nebo textové soubory přímo do chatu, multimodální podporu (vkládání obrázků do promptů), přizpůsobení délky kontextu pro práci s rozsáhlými dokumenty, využití příkazové řádky nebo SDK pro integraci do vlastních aplikací.

Nové modely lze také provozovat přes llama.cpp, GGML nebo Microsoft AI Foundry Local (ve veřejné preview verzi).

Svět AI se neustále rozvíjí a s ním i možnosti jejího lokálního využití. Nejnovější trendy, příklady použití a další zajímavé informace z tohoto světa přináší každý týden blog RTX AI Garage.